「活性化関数」の版間の差分

ナビゲーションに移動

検索に移動

imported>Administrator (ページの作成:「'''活性化関数'''(かっせいかかんすう)とは、入力信号の総和がどのように活性化するか(発火するか)を決定する役割を...」) |

imported>Administrator |

||

| 7行目: | 7行目: | ||

「[[多層パーセプトロン]](いわゆる最近流行りの[[機械学習]]の[[ニューラルネットワーク]])」の活性化関数では「[[シグモイド関数]]」「[[ReLU関数]]」「[[恒等関数]]」「[[ソフトマックス関数]]」などの[[非線形関数]]が使われる。 | 「[[多層パーセプトロン]](いわゆる最近流行りの[[機械学習]]の[[ニューラルネットワーク]])」の活性化関数では「[[シグモイド関数]]」「[[ReLU関数]]」「[[恒等関数]]」「[[ソフトマックス関数]]」などの[[非線形関数]]が使われる。 | ||

[[file:ReLU関数.png|none|ReLU関数の例]] | [[file:ReLU関数.png|none|ReLU関数の例]] | ||

| + | |||

| + | [[category: 機械学習]] | ||

2017年11月14日 (火) 01:29時点における版

活性化関数(かっせいかかんすう)とは、入力信号の総和がどのように活性化するか(発火するか)を決定する役割を持つ。 超大雑把にいえば、ニューロン(の樹状突起)から受け取った複数の入力信号を、火力を表す1つのスプライングラフ(折れ線グラフ)状に変換し、次のニューロンに受け渡す役割をする。

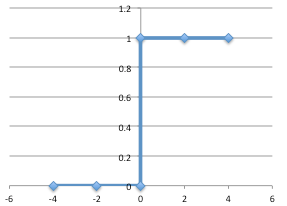

「単純パーセプトロン(配列を入力に受け取り0か1の数字を返す単純なニューラルネットワーク)」の活性化関数では「ステップ関数」などの線形関数が使われる。

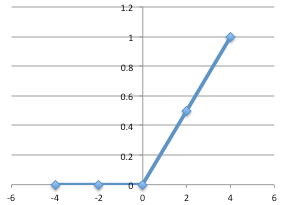

「多層パーセプトロン(いわゆる最近流行りの機械学習のニューラルネットワーク)」の活性化関数では「シグモイド関数」「ReLU関数」「恒等関数」「ソフトマックス関数」などの非線形関数が使われる。